Retrodigitalisierung: Die Grabungsdokumentation des Kastell Heidelberg-Neuenheim

Standardisierte Arbeitsabläufe zur Retrodigitalisierung am Fallbeispiel der Grabungsdokumentation Kastell Heidelberg-Neuenheim

Das Medium Papier bietet von Natur aus eine nur eingeschränkte Auswertbarkeit. Die auf Papierdokumenten festgehaltenen Informationen benötigen – um nicht nur vom Menschen, sondern auch von Maschinen interpretiert und weiterverarbeitet werden zu können – eine Aufarbeitung, beispielsweise durch das Anfertigen eines Scans und dem Abspeichern desselben als Datei. Über diesen Schritt der Digitalisierung hinaus geht die sogenannte Retrodigitalisierung, im Zuge derer das reine Digitalisat (in diesem Falle die Bilddatei) analysiert und Inhalte daraus zur weiteren, auf digitaler Ebene stattfindenden Verarbeitung extrahiert werden.

Papiermaterial ist hochsensibel gegenüber diverser Einflüsse wie Lagerumstände, Temperatur, Luftfeuchtigkeit und Sonneneinstrahlung, um nur wenige Beispiele zu nennen. In fast jedem Archiv und Museum oder Bibliothek lagern tausende Dokumente, die besonders auch in jüngerer Vergangenheit in den 1960 bis 1980er Jahren auf chlorhaltigem Papier erstellt wurden und dadurch einem massivem »Selbstverfall« unterliegen. Durch die Retrodigitalisierung können schriftliche Quellen, handschriftliche Pläne oder auch Fotoabzüge für künftige Forschungen bewahrt und für die Weiterbearbeitung mit digitalen Methoden aufbereitet werden.

Durch die Digitalisierung ist es möglich, große Datenmengen schnell zu vervielfältigen, was eine mehrfache Sicherung an unterschiedlichen Orten und auf unterschiedlichen Medien erlaubt, um so einem Totalverlust durch Feuer-, Wasserschaden etc. vorzubeugen. Selbstverständlich sind auch digitale Datenträgen nicht vor physischem Verfall gefeit. Zudem besteht die Gefahr, dass verwendete Datenträgertechnik obsolet wird und Daten nicht mehr zugreifbar werden. Gleiches gilt auch für Datenformate und Präsentationstechniken, wie sie z.B. auf Multimedia CDs in den 1990ern eingesetzt wurden. Es ist nicht der Anspruch des Projektes, all diese Probleme lösen zu wollen. Vielmehr sollen hier kleine Teilprobleme herausgegriffen werden und mithilfe von bereits bestehenden Lösungsansätzen im Rahmen einer großen Strategie praxistauglich umgesetzt werden. Das Projekt geht davon aus, dass digitale Kollektionen über einen größeren Zeitraum (15 Jahre und mehr) nicht ohne Migration und Transformation der Daten für den laufenden Forschungsbetrieb erhalten werden können. Um zukünftig auftretende Kosten hierfür möglichst gering zu halten, werden beschreibungsmächtige, internationale XML Metadatenstandards, wie z.B. MODS (Metadata Object Description Schema), VRA Core 4 (Visual Ressources Association) oder TEI (Text Encoding Initiative) eingesetzt. Diese Standards sind weltweit anerkannt, gut dokumentiert und machen es einfacher, die Informationen auch in Zukunft für den laufenden Forschungsbetrieb nutzbar zu machen bzw. zu halten. Bei nicht standardisierten Daten, die in projektspezifischen Insellösungen abgelegt wurden, ist die Wahrscheinlichkeit deutlich höher, dass zwar die Binärdaten inkl. Datenbankanwendung archiviert werden, die Funktionalität des Systems aber auf Dauer nicht erhalten werden kann, bzw. die Kosten dafür zu hoch werden. Ein weiterer Vorteil von internationalen Standards ist, dass die Daten nicht standortgebunden sind und auch jetzt schon einfacher zwischen Systemen und Institutionen ausgetauscht werden können. Dies hilft, die Zusammenarbeit zu vereinfachen, und erhöht den Kreis der Kandidaten, die in Zukunft in der Lage sein werden, die Informationen in funktionaler Form bereitzustellen und zu nutzen.

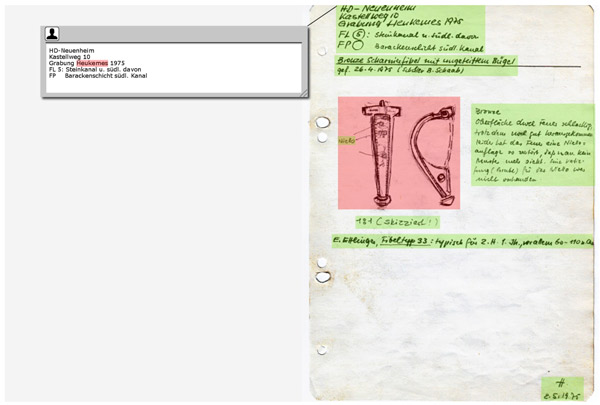

Fig. 1: Digitalisat des Grabungstagebuchs; Entwurf des Editors zur Annotation von Text und Bildbereichen mit Markierung eines Personennamens.

Aufbauend auf den umfangreichen Vorarbeiten der Projektpartner »Junior Research Group Digital Humanities« und der »Heidelberg Research Architecture« wird eine Core Facility entwickelt, die Retrodigitalisierung, Kollektionsmanagement und weitere wissenschaftliche Aufbereitung der Digitalisate zusammenbringt und nachhaltig nutzbare Forschungsdaten produziert. Ziel des Projektes ist es, die identifizierten Herausforderungen nicht nur unter gut finanzierten Laborbedingen im Rahmen einer projektspezifischen Insellösung zu behandeln, sondern – ganz im Sinne einer Core Facility – eine breit nachnutzbare Lösung über die Projektlaufzeit heraus zu entwickeln. Dieses Ziel vor Augen setzen wir auf etablierte Standards, um eine hohe Interoperabilität und Qualität zu gewährleisten – bei gleichzeitiger Geringhaltung von Zeitaufwand und Kosten für den Nutzer. Schulungen, eine ausführliche Dokumentation und der Einsatz in der Lehre sollen Akzeptanz und Nachhaltigkeit weiter stärken.

Alle während der Projektlaufzeit entstehenden Komponenten werden nahtlos in das seit 2010 von der Heidelberg Research Architecture entwickelte Tamboti Metaframework einfließen und so einem großen Nutzerkreis frei zur Verfügung gestellt.

Grundlage des inhaltlichen Teils der Fallstudie ist eine bisher unveröffentlichte Grabungsdokumentation aus dem Besitz des Kurpfälzischen Museums der Stadt Heidelberg, an dem das Vorhaben exemplarisch umgesetzt wird.

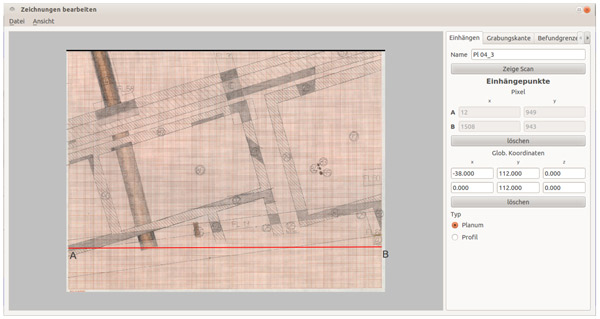

Fig. 2: Georeferenzierung und Entzerrung eines Teilscans einer Ausgrabungszeichung »Kastellweg 1975« des Kurpfälzischen Museums Stadt Heidelberg und Eingabe der korrespondierenden Koordinaten des lokalen Koordinatensystems (rechts); Tool Pantora (Matthias.Guth) im sogenannten »Einhängemoduls«.

Projektleiter

Dr. Armin Volkmann, ›Junior Research Group Digital Humanities and Digital Cultural Heritage‹

armin.volkmann@asia-europe.uni-heidelberg.de

Institutionelle Anbindung

In Zusammenarbeit mit der ›Heidelberg Research Architecture‹, Eric Decker.

Förderung

Anschubfinanzierung durch das Research Council FoF3.

Kontakt

Dr. Armin Volkmann

Junior Research Group Leader »Digital Humanities/Digital Cultural Heritage«

Cluster of Excellence »Asia and Europe in a Global Context«

Heidelberg University

Karl Jaspers Centre

Vossstr. 2

Building 4400, Room 005a

69115 Heidelberg

Germany

Telephone: +49 (0)6221 54-4310